728x90

반응형

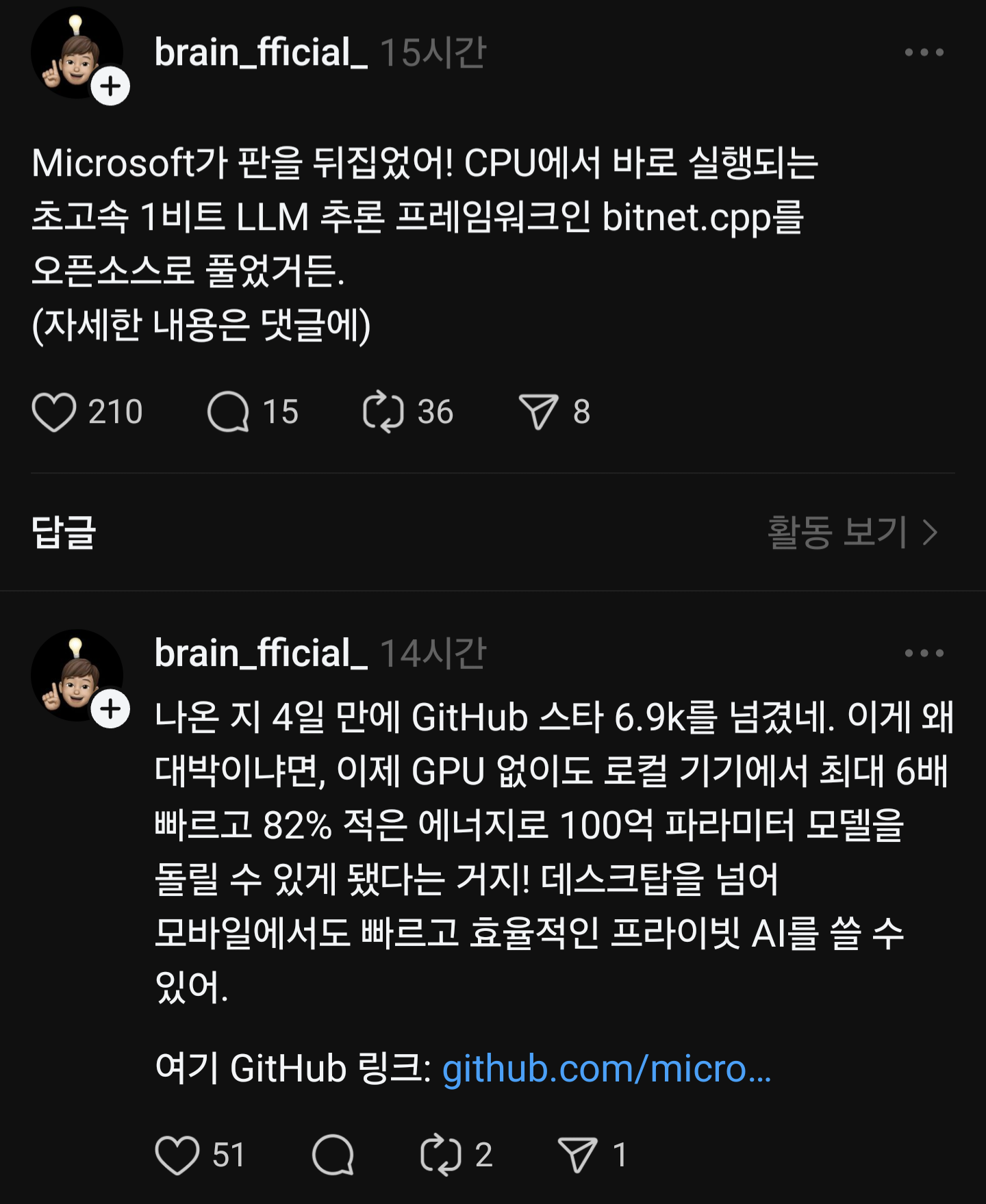

인스타 보다가 우연히 본 쓰레드 게시글

INT-8 형식은 잘 채택하지 않는것으로 알고 있는데, FP-16을 대체할 수 있다는 류의 내용이라 흥미가 생겼다.

Transformer 알고리즘을 공부하고 HW 설계를 해볼 생각이였는데, 마침 좋은 공부를 할 수 있을 것 같다.

https://github.com/microsoft/BitNet

GitHub - microsoft/BitNet: Official inference framework for 1-bit LLMs

Official inference framework for 1-bit LLMs. Contribute to microsoft/BitNet development by creating an account on GitHub.

github.com

논문 오픈소스 github 링크

엣지 디바이스 환경에서도 LLM을 쓸수 있게 될까?!

충분히 FPGA로 구현해볼 만 한 주제인 것 같다!!

설렌다.

여담) 16bit 폰노이만 구조 CPU를 설계하였다!

나중에 포스팅 예정

728x90

반응형